🐱網膜光凝固術:左2回目 ― 2024年04月24日 13:46

網膜光凝固術:左2回目

午前中、眼科に行って目玉焼き(!)。

今日は、糖尿病網膜症の治療として、レーザー網膜光凝固術左目の2回目だ。

前回は、下半分を焼いたんだが、今回は上半分を中心に焼く。

先生の話では、いい焼き上がり具合(!)で、次回は周辺部をメインに仕上げていく予定という。

右目については、黄斑浮腫があるため、慎重に検討するということで了解した(一応、同意書は両眼で書いています)。

今回は、施術中の痛みは前回ほど感じなかったし、施術直後の視野の喪失等もそれほどない。

慣れたのかもな(そうなのかあ?)。

帰ってきて、ステロイド剤入りの目薬を差したんだが、意外に沁みたのが気になる程度だ。

眼科に行く前に、かかりつけの内科に受診。

先月、久米島ツアー直後で、爆食したために先送りした採血を行う(無駄な抵抗はやめろ・・・)。

明後日には結果が出てくる。

糖尿病のコントロールは十分にできているはずなんだが、眼病は勝手に進行するからな。

焼いて止める!。

新生血管が出来るのを、その相手先の細胞を殺してしまって阻止しようという戦略だ(血管を誘導する因子を出させないわけだな)。

予防的治療法としては、余りスマートな感じはしない。

が、背に腹は代えられない。

失明か、視力等の低下か。

リスク手間暇経済損失(3割負担で片目5万円!)と期待される効果(症状の進行を遅らせるだけ)を天秤して、目玉焼きを選んだ。

右目は、左目の視力検査、視野検査を評価してから行うという。

どのくらいの低下で凌げるか。

日常生活への支障(自動車の運転が一番気になる)、予後の見通し、右目の黄斑浮腫の進行などを勘案して、総合的に戦略を立てる。

余命との相談もあるからな。

見えている時間とその質との兼ね合い・・・。

我が事とは言いながら、なかなかせつない話ではある。

まあいい。

2度目の施術は、覚悟が出来ていたせいか、精神的には初回に比べれば楽だった。

今日は、念のためにフィットネスはサボリ(小雨だしな:雨の日は、基本的にサボる)。

明日は、残念ながら晴れるそうだ(そういう態度でいいのかあ?)。

定期的な運動は、二型糖尿病の管理にも効果があるしな。

生きているのが仕事な年金生活だが、それだって楽な話じゃない。

目玉焼いたり、筋トレしたり・・・。

3回目の施術の際は、コンタクトレンズを変えるそうだ(レーザー当てる際に、コンタクトレンズを入れます)。

周囲を焼くということで、別のレンズにするらしい(詳細不明)。

お任せだからな。

まな板の上のコイ(画像はイメージです)。

レーザーで目玉焼いてる浮沈子・・・。

午前中、眼科に行って目玉焼き(!)。

今日は、糖尿病網膜症の治療として、レーザー網膜光凝固術左目の2回目だ。

前回は、下半分を焼いたんだが、今回は上半分を中心に焼く。

先生の話では、いい焼き上がり具合(!)で、次回は周辺部をメインに仕上げていく予定という。

右目については、黄斑浮腫があるため、慎重に検討するということで了解した(一応、同意書は両眼で書いています)。

今回は、施術中の痛みは前回ほど感じなかったし、施術直後の視野の喪失等もそれほどない。

慣れたのかもな(そうなのかあ?)。

帰ってきて、ステロイド剤入りの目薬を差したんだが、意外に沁みたのが気になる程度だ。

眼科に行く前に、かかりつけの内科に受診。

先月、久米島ツアー直後で、爆食したために先送りした採血を行う(無駄な抵抗はやめろ・・・)。

明後日には結果が出てくる。

糖尿病のコントロールは十分にできているはずなんだが、眼病は勝手に進行するからな。

焼いて止める!。

新生血管が出来るのを、その相手先の細胞を殺してしまって阻止しようという戦略だ(血管を誘導する因子を出させないわけだな)。

予防的治療法としては、余りスマートな感じはしない。

が、背に腹は代えられない。

失明か、視力等の低下か。

リスク手間暇経済損失(3割負担で片目5万円!)と期待される効果(症状の進行を遅らせるだけ)を天秤して、目玉焼きを選んだ。

右目は、左目の視力検査、視野検査を評価してから行うという。

どのくらいの低下で凌げるか。

日常生活への支障(自動車の運転が一番気になる)、予後の見通し、右目の黄斑浮腫の進行などを勘案して、総合的に戦略を立てる。

余命との相談もあるからな。

見えている時間とその質との兼ね合い・・・。

我が事とは言いながら、なかなかせつない話ではある。

まあいい。

2度目の施術は、覚悟が出来ていたせいか、精神的には初回に比べれば楽だった。

今日は、念のためにフィットネスはサボリ(小雨だしな:雨の日は、基本的にサボる)。

明日は、残念ながら晴れるそうだ(そういう態度でいいのかあ?)。

定期的な運動は、二型糖尿病の管理にも効果があるしな。

生きているのが仕事な年金生活だが、それだって楽な話じゃない。

目玉焼いたり、筋トレしたり・・・。

3回目の施術の際は、コンタクトレンズを変えるそうだ(レーザー当てる際に、コンタクトレンズを入れます)。

周囲を焼くということで、別のレンズにするらしい(詳細不明)。

お任せだからな。

まな板の上のコイ(画像はイメージです)。

レーザーで目玉焼いてる浮沈子・・・。

🐱AI:Phi-3:コスト効率 ― 2024年04月24日 21:10

AI:Phi-3:コスト効率

(Microsoftがコスト効率の高い小さめの言語モデル「Phi-3」をリリース、オープンモデルで商用利用可能)

https://gigazine.net/news/20240424-microsoft-phi-3/

「Microsoftが小さい規模で大きな性能を発揮する言語モデルとして「Phi-3」ファミリーをリリース」

「一番小さなサイズのモデルであるPhi-3-miniはオープンモデルとなっており、無料で商用利用が可能」

リンクと使用方法が紹介されていたので、つべこべ言わずに早速使ってみた。

質問は、例の2つだな・・・。

(Phi-3-mini-128k-instruct:公開モデルへのダイレクトなリンクになります。)

https://ai.azure.com/explore/models/Phi-3-mini-128k-instruct/version/2/registry/azureml

「Q.地球外生命はいますか」

「A.地球外生命の存在については、科学的な証拠がない限り、確認はできません。宇宙は広く、多様な環境が存在していますが、人類による探査では、直接的な証拠は見つからなかったところもあります。しかし、宇宙の広さと多様性により、地球外生命の存在は推測されることもありますが、それは科学的な証拠に基づいていません。」

「Q.火星移民は可能ですか」

「A.火星移民の可能性は、現在の宇宙探査技術と宇宙飛行に関する進歩に依存します。現在、人類は火星に直接行ったり、長期的な居住を考えていません。しかし、火星の研究においては、火星探査機や将来の宇宙飛行機などが開発されており、これらの技術の進歩が火星移民の可能性を高めるかもしれません。また、火星の資源を利用するための技術開発も重要であり、これらの技術が進化すれば、火星移民の実現に向けた重要なステップとなるでしょう。」

デフォルトでは、「max_tokens」が128に設定されていて、回答が途中でちょん切れてしまったので、試しに設定ボタンを押して256に変更したら、上記の通り、それらしい回答になった。

浮沈子的評価は悪くない。

可能性は排除しないが、蓋然性を直ちに認めるというスタンスではないからな。

妥当な回答と感じた。

まあ、どうでもいいんですが。

ちなみに、プロンプトは日本語で投げていて、回答も日本語で出てきた。

リンク先には、左側に詳細な説明が出ている。

「モデル詳細:

Phi-3 Mini-128K-Instruct は、Phi-2 に使用されるデータセット (合成データとフィルタリングされた Web サイト) に基づいて構築された 3.8B パラメーターの軽量で最先端のオープン モデルであり、非常に高品質な推論に重点を置いています。 緻密なデータ。

このモデルは Phi-3 モデル ファミリに属しており、Mini バージョンには、サポートできるコンテキスト長 (トークン単位) である 4K と 128K の 2 つのバリアントがあります。 このモデルは、厳密な強化プロセスを経て、教師付き微調整と直接優先最適化の両方を組み込んで、正確な指示遵守と堅牢な安全対策を確保しました。

常識、言語理解、数学、コード、長いコンテキスト、論理的推論をテストするベンチマークに対して評価した場合、Phi-3 Mini-128K-Instruct は、130 億未満のパラメータを持つモデルの中で堅牢かつ最先端のパフォーマンスを示しました。」

トレーニングの詳細、使用目的等についても記述があるが、割愛する。

ギガジンの記事や、このページの説明を読む限りでは、MoEではないようだ(未確認)。

トレーニングデータを厳選し、調整を行って高いパフォーマンスを得ていると思われる。

「Phi-3ファミリーには他に70億(7B)パラメーターの「Phi-3-small」と140億(14B)パラメーターの「Phi-3-medium」が存在しており、この2つのモデルについては近いうちにAzure AIモデルカタログにて利用可能になる予定」(ギガジンの記事)

「Mixtral 8x7BやLlama 3 8B、Gemma 7B、Mistral 7Bなどオープンなモデルとの比較は下図の通り。」(画像参照)

MoEモデルについては、アクティブなパラメーター数を採用して比較しており、公平な評価といえよう。

「Phi-3のいずれのモデルも自身より大きいサイズのモデルに勝てる性能を発揮していると言えますが、モデルサイズが小さいことで事実を記憶できる容量が減り、TriviaQAなど事実知識を計測するベンチマークではあまり結果が良くありません。」

まあ、そこは仕方ないな。

AIについて追いかけ始めてから、毎週のように新しいモデルがリリースされる気がする(つーか、記事になる)。

登録しないでも、勝手に触われるモデルしか試していないけど(といっても、怪しげな質問を2つほどするだけですが)、何となくAIに親しんでいる気になれる(まあ、そんなもんです・・・)。

チャットGPTが火を点けたAIバブルは既に弾けたかもしれないが、巷の認知や活用はこれからだろう。

このファイ3ミニにしても、自前で動かすにはH100などのGPUが必要だ(一部の報道では、スマホで動くとか言ってるけどな)。

(Microsoft、商用利用可のSLM「Phi-3」リリース スマホで動くモデルも)

https://www.itmedia.co.jp/news/articles/2404/24/news100.html

「Microsoftは関連論文で、パラメータを4ビットに圧縮したPhi-3-miniがiPhoneのA16 Bionicチップ上で1秒あたり12トークン以上を生成できたと紹介した。」(ホントかあ?)

「米NVIDIAによると、Phi-3-miniは「RTX GPU」搭載のワークステーションや「GeForce RTX GPU」搭載のPCでローカルに実行可能という。」(こっちは、ありそうな気がするけどな)

また、リアルな情報のブラッシュアップがどうなるかは不明だ。

「ステータス: これは、カットオフ日が 2023 年 10 月のオフライン データセットでトレーニングされた静的モデルです。モデルの改良に応じて、調整されたモデルの将来のバージョンがリリースされる可能性があります。」(リンク先のページ)

もちろん、現在のところ、マルチモーダルではない。

が、教育と推論のコストを下げながら、高い性能を維持するノウハウ(データセットの品質向上と微調整)が、AIの一つのカギになるという好例に違いない。

MoEだけじゃないってことなわけだ。

省エネ省資源という観点からも、こういうアプローチがあるということは重要だな・・・。

(Microsoftがコスト効率の高い小さめの言語モデル「Phi-3」をリリース、オープンモデルで商用利用可能)

https://gigazine.net/news/20240424-microsoft-phi-3/

「Microsoftが小さい規模で大きな性能を発揮する言語モデルとして「Phi-3」ファミリーをリリース」

「一番小さなサイズのモデルであるPhi-3-miniはオープンモデルとなっており、無料で商用利用が可能」

リンクと使用方法が紹介されていたので、つべこべ言わずに早速使ってみた。

質問は、例の2つだな・・・。

(Phi-3-mini-128k-instruct:公開モデルへのダイレクトなリンクになります。)

https://ai.azure.com/explore/models/Phi-3-mini-128k-instruct/version/2/registry/azureml

「Q.地球外生命はいますか」

「A.地球外生命の存在については、科学的な証拠がない限り、確認はできません。宇宙は広く、多様な環境が存在していますが、人類による探査では、直接的な証拠は見つからなかったところもあります。しかし、宇宙の広さと多様性により、地球外生命の存在は推測されることもありますが、それは科学的な証拠に基づいていません。」

「Q.火星移民は可能ですか」

「A.火星移民の可能性は、現在の宇宙探査技術と宇宙飛行に関する進歩に依存します。現在、人類は火星に直接行ったり、長期的な居住を考えていません。しかし、火星の研究においては、火星探査機や将来の宇宙飛行機などが開発されており、これらの技術の進歩が火星移民の可能性を高めるかもしれません。また、火星の資源を利用するための技術開発も重要であり、これらの技術が進化すれば、火星移民の実現に向けた重要なステップとなるでしょう。」

デフォルトでは、「max_tokens」が128に設定されていて、回答が途中でちょん切れてしまったので、試しに設定ボタンを押して256に変更したら、上記の通り、それらしい回答になった。

浮沈子的評価は悪くない。

可能性は排除しないが、蓋然性を直ちに認めるというスタンスではないからな。

妥当な回答と感じた。

まあ、どうでもいいんですが。

ちなみに、プロンプトは日本語で投げていて、回答も日本語で出てきた。

リンク先には、左側に詳細な説明が出ている。

「モデル詳細:

Phi-3 Mini-128K-Instruct は、Phi-2 に使用されるデータセット (合成データとフィルタリングされた Web サイト) に基づいて構築された 3.8B パラメーターの軽量で最先端のオープン モデルであり、非常に高品質な推論に重点を置いています。 緻密なデータ。

このモデルは Phi-3 モデル ファミリに属しており、Mini バージョンには、サポートできるコンテキスト長 (トークン単位) である 4K と 128K の 2 つのバリアントがあります。 このモデルは、厳密な強化プロセスを経て、教師付き微調整と直接優先最適化の両方を組み込んで、正確な指示遵守と堅牢な安全対策を確保しました。

常識、言語理解、数学、コード、長いコンテキスト、論理的推論をテストするベンチマークに対して評価した場合、Phi-3 Mini-128K-Instruct は、130 億未満のパラメータを持つモデルの中で堅牢かつ最先端のパフォーマンスを示しました。」

トレーニングの詳細、使用目的等についても記述があるが、割愛する。

ギガジンの記事や、このページの説明を読む限りでは、MoEではないようだ(未確認)。

トレーニングデータを厳選し、調整を行って高いパフォーマンスを得ていると思われる。

「Phi-3ファミリーには他に70億(7B)パラメーターの「Phi-3-small」と140億(14B)パラメーターの「Phi-3-medium」が存在しており、この2つのモデルについては近いうちにAzure AIモデルカタログにて利用可能になる予定」(ギガジンの記事)

「Mixtral 8x7BやLlama 3 8B、Gemma 7B、Mistral 7Bなどオープンなモデルとの比較は下図の通り。」(画像参照)

MoEモデルについては、アクティブなパラメーター数を採用して比較しており、公平な評価といえよう。

「Phi-3のいずれのモデルも自身より大きいサイズのモデルに勝てる性能を発揮していると言えますが、モデルサイズが小さいことで事実を記憶できる容量が減り、TriviaQAなど事実知識を計測するベンチマークではあまり結果が良くありません。」

まあ、そこは仕方ないな。

AIについて追いかけ始めてから、毎週のように新しいモデルがリリースされる気がする(つーか、記事になる)。

登録しないでも、勝手に触われるモデルしか試していないけど(といっても、怪しげな質問を2つほどするだけですが)、何となくAIに親しんでいる気になれる(まあ、そんなもんです・・・)。

チャットGPTが火を点けたAIバブルは既に弾けたかもしれないが、巷の認知や活用はこれからだろう。

このファイ3ミニにしても、自前で動かすにはH100などのGPUが必要だ(一部の報道では、スマホで動くとか言ってるけどな)。

(Microsoft、商用利用可のSLM「Phi-3」リリース スマホで動くモデルも)

https://www.itmedia.co.jp/news/articles/2404/24/news100.html

「Microsoftは関連論文で、パラメータを4ビットに圧縮したPhi-3-miniがiPhoneのA16 Bionicチップ上で1秒あたり12トークン以上を生成できたと紹介した。」(ホントかあ?)

「米NVIDIAによると、Phi-3-miniは「RTX GPU」搭載のワークステーションや「GeForce RTX GPU」搭載のPCでローカルに実行可能という。」(こっちは、ありそうな気がするけどな)

また、リアルな情報のブラッシュアップがどうなるかは不明だ。

「ステータス: これは、カットオフ日が 2023 年 10 月のオフライン データセットでトレーニングされた静的モデルです。モデルの改良に応じて、調整されたモデルの将来のバージョンがリリースされる可能性があります。」(リンク先のページ)

もちろん、現在のところ、マルチモーダルではない。

が、教育と推論のコストを下げながら、高い性能を維持するノウハウ(データセットの品質向上と微調整)が、AIの一つのカギになるという好例に違いない。

MoEだけじゃないってことなわけだ。

省エネ省資源という観点からも、こういうアプローチがあるということは重要だな・・・。

🐱AI:ガウディ3:水冷も! ― 2024年04月24日 22:08

AI:ガウディ3:水冷も!

(IntelがNVIDIAに対抗して発表したAIアクセラレータ「Gaudi 3」の実物写真が公開中)

https://gigazine.net/news/20240423-intel-gaudi-3-photo-report/

「Gaudi 3は空冷式と水冷式が用意されるとのことで、量産品は空冷式が2024年第3四半期(7月~9月)、水冷式が2024年第4四半期(10月~12月)にリリースされる予定」

独走するエヌビディアに待ったをかけられるかどうか。

「Intelは、Gaudi 3がAI学習性能とAI推論性能の両面でNVIDIAのAI特化GPU「H100」よりも高い性能を発揮すると述べており、2024年後半に量産を開始する予定」

「2020年に発表された前世代のGaudi 2は7nmプロセスで設計されていますが、Gaudi 3は5nmプロセスで設計されています。」

「シリコンパッケージは2つのダイで構成されており、それぞれに48MBのSRAM、16個のTPC(テンソル処理コア)、メディアエンジンが搭載」

このAIチップについては、以前にも取り上げている。

(AI:AIチップの味)

http://kfujito2.asablo.jp/blog/2024/04/12/9675288

「(IntelがAIアクセラレータ「Gaudi 3」を発表、NVIDIAのH100より高速かつ低消費電力で一部テストではH200にも勝利)

https://gigazine.net/news/20240410-intel-ai-accelerator-gaudi-3/

「IntelがAIアクセラレータ「Gaudi 3」を2024年4月9日に発表しました。」

「NVIDIAのAI特化GPU「H100」よりも高い性能」」

インテルとしては、エヌビディアの独走を許すわけにはいかないだろう。

コンパクトな言語モデルが登場してきているとはいえ、スーパーLLMの需要はまだまだ続くに違いない。

また、サービスとしてのAIの活用だけではなく、自らホストしてチューニングしたいという要求もあるはずだ。

クラウドサイドのAIだって、これからいくらでも大化けしそうな予感がする。

もっとも、データセンターのエネルギー的(電力や冷却能力)ネックが問題だがな。

年内には、H200がリリースされると言われているが、ガウディ3はそれも上回るとされているようだ。

(NVIDIA H200 Tensor コア GPU)

https://www.nvidia.com/ja-jp/data-center/h200/

「この製品が発売開始になりましたらお知らせいたします。」

まあ、出てみなければ分からんけどな。

MoEや、教育の最適化で、スケール的な問題が高度に解決されれば、今度はその手法をスケールアップして大規模モデルに適用し、一層大規模にしてハイパーLLMへと進化することは目に見えている。

数(規模)は正義だ。

そういった言語ベースの進化と同時に、マルチモーダル化という流れも見えてきている。

チップベースで、それをどう実現するのかは知らない。

いずれにしても、計算資源があり過ぎて困ることはない。

質より量とは言わないけど、AIの世界で量は絶対の正義だろう。

質も量も、湯水のごとく消費される世界だ。

水冷チップなんて、久々な気がする(浮沈子が知らないだけかも)。

ブラウン管なモニターとにらめっこし、ハードディスクをスタックして自作していた時代は歴史の彼方に消えた。

AIチップの世界もまた、言語モデルと同様に、絶え間ない進化が続きそうだな・・・。

<以下追加>ーーーーーーーーーー

(NVIDIA Blackwell GPU 発表!)

https://gdep-sol.co.jp/news-nvidia-brackwell-gpu-gtc24/

「NVIDIA最大の開発者向けカンファレンス「NVIDIA GTC 2024」において、新しいGPUアーキテクチャ「Blackwell」が発表されました。」

「「Blackwell GPU」は、データセンターやサーバー向けのGPUとなり、NVIDIA H100 などの「Hopper GPU」の後継となります。」

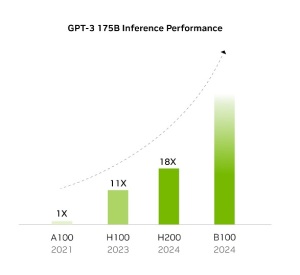

引用したエヌビディアのページのグラフ(画像参照)に出ていたので、ちょろっと調べたら、1か月余り前に発表されていた。

「「Blackwell」は、2024年後半から発売開始予定となり、数兆パラメータの大規模言語モデルによるリアルタイム生成 AI を構築・実行することができると発表しています。」

べらぼーめ・・・。

アーキテクチャの流れは以下の通り。

・2020年発表 Ampere アーキテクチャ(NVIDIA A100 Tensor Core GPU)

・2022年発表 Hopper アーキテクチャ(NVIDIA H100 Tensor Core GPU)

・2024年発表 Blackwell アーキテクチャ(NVIDIA B100 Tensor Core GPU)

なお、実際の製品名は、どうやらB200がメインで、B100というのは性能を落とした普及版らしい(未確認)。

(AI特化設計になったNVIDIA Blackwell、並列性を向上する仕組みが強化)

https://pc.watch.impress.co.jp/docs/column/ubiq/1577897.html

「NVIDIAは3月18日~3月20日(米国時間)の3日間に渡り、同社のAIやデータセンター向け半導体などに関する話題を扱うフラグシップ年次イベント「GTC」を、米国カリフォルニア州サンノゼのサンノゼコンベンションセンターにおいて開催」

「基調講演の中で、新しいAI/データセンター向けGPUアーキテクチャ「Blackwell」が発表」

「最初の製品として「NVIDIA B200 Tensor Core GPU」(以下B200)、「NVIDIA GB200 Superchip」(以下GB200)の2つを今年(2024年)中に投入する計画」

「今回発表されたBlackwellにはTDPの違いで3つのグレードの製品が用意」(Thermal Design Power:熱設計電力)

「GB200に採用されているフルスペックのB200は、前述の通り1,200WのTDPになっている。それに対してDGX B200やHGX B200に採用されているB200は、TDPが1,000Wになっており、それに合わせてフルスペックのB200に比べてクロック周波数や演算器の数などが少し下げられている」(どのように調整しているかは非公表)

「さらに、下位モデルとしてB100という製品も用意される。」(700Wという従来のH100と同じTDP)

「いずれも2ダイ/1パッケージは同様(その証拠にメモリ帯域や容量などはB200と変わらない)」

「このB100では、H100 SXMに比べるとFP64の数字は劣っているが、Tensorコアを利用した演算では上回っている、そうした位置づけの製品」

記事には、性能を比較した表が載っているので、興味がある方はそちらを参照されたい。

<Blackwell製品>

・B200(GB200版)

・B200(DGX/HGX版)

・B100(HGX版)

<Hopper製品:参考?>

・Hopper(H100 SXM)

まあ、どうでもいいんですが。

もう、H200とかは、飛ばされている感じだな。

門外漢の浮沈子には、さっぱりな記事だが、気になる点もある。

「Transformerモデルでは、MoE(mixture of experts)と呼ばれる手法を使って並列性を高めることが行なわれている。」

「MoEで演算をする場合、1つのGPUがほかのGPUの処理が終わるまで待つということが発生する。また、複数のGPUでデータのやりとりを行なったりすることに、GPUの処理能力の60%を消費している」

「大規模に並列化されたGPUにおいてそうした「無駄」が生じており、それを削減することに大きな意味がある」

「新しいTransformerモデルの並列性向上手法(EP:Expert Parallelism、TP:Tensor Parallelism)をさらに2分割することで、Blackwellのようなより並列性が高くなっている製品ではAI学習がさらに効率よく演算でき、かつGPU同士の通信を減らして演算効率を上げることが可能」

ダイの製造限界から、2ダイ構成にしたわけだが、転んでもただでは起きないわけだ。

言語モデルの構造を、AIチップ構成に織り込んでいる。

「新しいソフトウェアのトレンドにも対応することで、ハードウェアのレベルでも、ソフトウェアのレベルでも並列性を高めてより効率よくAI学習を実行したようにしたのがBlackwellの狙い」

インテルは、またしても突き放されることになるのではないか。

AMDも追随していると言われるが、浮沈子的には未調査だ。

この件、何かあればまた書く。

<さらに追加>ーーーーーーーーーー

(NVIDIAがデータセンター向けGPU市場で98%のシェアを独占していることが判明、AI性能が明暗を分ける結果に)

https://gigazine.net/news/20240205-nvidia-gpu-market/

「2023年のデータセンター向けGPU市場におけるNVIDIAのシェアが98%」

べらぼーめい・・・。

元になったXへの投稿は、やっぱヤバ過ぎたのか、削除されているようだ。

まあいい。

「2023年におけるNVIDIAのデータセンター向けGPUの売上は372億ドル(約5兆5220億円)で、2024年には457億ドル(約6兆7840億円)の収益を上げると予測されているとのこと。これに対し、2番手であるAMDの収益はそれぞれ4億6100万ドル(約684億2500万円)と21億ドル(約3110億円)に過ぎない」

やれやれ・・・。

「一方、Intelは次期AIチップの「Gaudi 3」でNVIDIAのH100やAMDのMI300に対抗するとしていますが、上記のグラフの通りシェア奪還はごくわずかにとどまるとの公算が大きい」(グラフは削除されています。)

「192GBのRAMと8枚のカードを備えたAMDのMI300Xは前世代のMI250を大きくしのぐ性能を秘めている」

色々調べたんだが、この記事が分かりやすい。

(AI=NVIDIAの牙城を崩すAMDの新GPU「Instinct MI300X」)

https://pc.watch.impress.co.jp/docs/column/ubiq/1553731.html

「AMDは、同社がNVIDIA H100対抗と位置付けるGPUの「Instinct MI300X」、APUの「Instinct MI300A」という2つの製品を発表」

「前者はデータセンターでのAI学習・推論向け、後者はデータセンターでのHPC処理向け」(HPC:ハイパフォーマンスコンピューティング:ここではAI用途以外の高速大容量処理用途らしい)

性能としてはAMDのインスティンクトの方が名目上は上な感じだが、業界の流れを変えることが出来るかどうかはビミョーだ(2024年中はムリポ)。

もう、クラウドサイドのAIチップは、エヌビディア一択と言って差し支えない。

既に見たように、Blackwellアーキテクチャへのシフトが始まっているしな。

すると、H200の位置付けは、単なるつなぎということになる。

(NVIDIAがAIおよびHPC向けGPU「H200」を発表、H100と比べて推論速度が2倍でHPC性能はx86 CPUの110倍)

https://gigazine.net/news/20231114-nvidia-h200-hopper/

「新たに発表されたH200には高速かつ大容量なメモリ技術「HBM3e」が採用されており、メモリ容量は141GB、メモリ帯域幅は4.8TB毎秒に達しています。H200は高性能なメモリを採用することでH100と比べて2倍の推論速度を実現」

市場投入時期も、ほぼ同時ということになりかねない。

N社は、収益を最大化するために、売り手市場での独占的地位を最大限に利用するだろう。

市場はAIチップに飢えている。

AMDは、この異常な状況の中で、H100同等程度の性能で勝負しようとしている。

それはインテルも同じだ。

N社は、市場の動きを見ながら、H100からH200への切り替え時期、B100シリーズの投入のタイミングを計ることが出来る。

状況が動くとしたら、2025年以降だろうな。

少なくとも今年はN社の一人勝ちが続くだろう。

<さらにさらに追加>ーーーーーーーーーー

(NVIDIA、データセンター向けGPU市場におけるシェアが98%!)

https://note.com/salty02/n/n4dda633066c7

「生成AIブームの中、大企業がこぞって演算力の高いGPUの確保に奔走。」

削除されていたグラフも、画像として残っていた!。

なんと、2018年以降は、90%台を維持している。

昨日今日始まった話ではないのだ・・・。

(IntelがNVIDIAに対抗して発表したAIアクセラレータ「Gaudi 3」の実物写真が公開中)

https://gigazine.net/news/20240423-intel-gaudi-3-photo-report/

「Gaudi 3は空冷式と水冷式が用意されるとのことで、量産品は空冷式が2024年第3四半期(7月~9月)、水冷式が2024年第4四半期(10月~12月)にリリースされる予定」

独走するエヌビディアに待ったをかけられるかどうか。

「Intelは、Gaudi 3がAI学習性能とAI推論性能の両面でNVIDIAのAI特化GPU「H100」よりも高い性能を発揮すると述べており、2024年後半に量産を開始する予定」

「2020年に発表された前世代のGaudi 2は7nmプロセスで設計されていますが、Gaudi 3は5nmプロセスで設計されています。」

「シリコンパッケージは2つのダイで構成されており、それぞれに48MBのSRAM、16個のTPC(テンソル処理コア)、メディアエンジンが搭載」

このAIチップについては、以前にも取り上げている。

(AI:AIチップの味)

http://kfujito2.asablo.jp/blog/2024/04/12/9675288

「(IntelがAIアクセラレータ「Gaudi 3」を発表、NVIDIAのH100より高速かつ低消費電力で一部テストではH200にも勝利)

https://gigazine.net/news/20240410-intel-ai-accelerator-gaudi-3/

「IntelがAIアクセラレータ「Gaudi 3」を2024年4月9日に発表しました。」

「NVIDIAのAI特化GPU「H100」よりも高い性能」」

インテルとしては、エヌビディアの独走を許すわけにはいかないだろう。

コンパクトな言語モデルが登場してきているとはいえ、スーパーLLMの需要はまだまだ続くに違いない。

また、サービスとしてのAIの活用だけではなく、自らホストしてチューニングしたいという要求もあるはずだ。

クラウドサイドのAIだって、これからいくらでも大化けしそうな予感がする。

もっとも、データセンターのエネルギー的(電力や冷却能力)ネックが問題だがな。

年内には、H200がリリースされると言われているが、ガウディ3はそれも上回るとされているようだ。

(NVIDIA H200 Tensor コア GPU)

https://www.nvidia.com/ja-jp/data-center/h200/

「この製品が発売開始になりましたらお知らせいたします。」

まあ、出てみなければ分からんけどな。

MoEや、教育の最適化で、スケール的な問題が高度に解決されれば、今度はその手法をスケールアップして大規模モデルに適用し、一層大規模にしてハイパーLLMへと進化することは目に見えている。

数(規模)は正義だ。

そういった言語ベースの進化と同時に、マルチモーダル化という流れも見えてきている。

チップベースで、それをどう実現するのかは知らない。

いずれにしても、計算資源があり過ぎて困ることはない。

質より量とは言わないけど、AIの世界で量は絶対の正義だろう。

質も量も、湯水のごとく消費される世界だ。

水冷チップなんて、久々な気がする(浮沈子が知らないだけかも)。

ブラウン管なモニターとにらめっこし、ハードディスクをスタックして自作していた時代は歴史の彼方に消えた。

AIチップの世界もまた、言語モデルと同様に、絶え間ない進化が続きそうだな・・・。

<以下追加>ーーーーーーーーーー

(NVIDIA Blackwell GPU 発表!)

https://gdep-sol.co.jp/news-nvidia-brackwell-gpu-gtc24/

「NVIDIA最大の開発者向けカンファレンス「NVIDIA GTC 2024」において、新しいGPUアーキテクチャ「Blackwell」が発表されました。」

「「Blackwell GPU」は、データセンターやサーバー向けのGPUとなり、NVIDIA H100 などの「Hopper GPU」の後継となります。」

引用したエヌビディアのページのグラフ(画像参照)に出ていたので、ちょろっと調べたら、1か月余り前に発表されていた。

「「Blackwell」は、2024年後半から発売開始予定となり、数兆パラメータの大規模言語モデルによるリアルタイム生成 AI を構築・実行することができると発表しています。」

べらぼーめ・・・。

アーキテクチャの流れは以下の通り。

・2020年発表 Ampere アーキテクチャ(NVIDIA A100 Tensor Core GPU)

・2022年発表 Hopper アーキテクチャ(NVIDIA H100 Tensor Core GPU)

・2024年発表 Blackwell アーキテクチャ(NVIDIA B100 Tensor Core GPU)

なお、実際の製品名は、どうやらB200がメインで、B100というのは性能を落とした普及版らしい(未確認)。

(AI特化設計になったNVIDIA Blackwell、並列性を向上する仕組みが強化)

https://pc.watch.impress.co.jp/docs/column/ubiq/1577897.html

「NVIDIAは3月18日~3月20日(米国時間)の3日間に渡り、同社のAIやデータセンター向け半導体などに関する話題を扱うフラグシップ年次イベント「GTC」を、米国カリフォルニア州サンノゼのサンノゼコンベンションセンターにおいて開催」

「基調講演の中で、新しいAI/データセンター向けGPUアーキテクチャ「Blackwell」が発表」

「最初の製品として「NVIDIA B200 Tensor Core GPU」(以下B200)、「NVIDIA GB200 Superchip」(以下GB200)の2つを今年(2024年)中に投入する計画」

「今回発表されたBlackwellにはTDPの違いで3つのグレードの製品が用意」(Thermal Design Power:熱設計電力)

「GB200に採用されているフルスペックのB200は、前述の通り1,200WのTDPになっている。それに対してDGX B200やHGX B200に採用されているB200は、TDPが1,000Wになっており、それに合わせてフルスペックのB200に比べてクロック周波数や演算器の数などが少し下げられている」(どのように調整しているかは非公表)

「さらに、下位モデルとしてB100という製品も用意される。」(700Wという従来のH100と同じTDP)

「いずれも2ダイ/1パッケージは同様(その証拠にメモリ帯域や容量などはB200と変わらない)」

「このB100では、H100 SXMに比べるとFP64の数字は劣っているが、Tensorコアを利用した演算では上回っている、そうした位置づけの製品」

記事には、性能を比較した表が載っているので、興味がある方はそちらを参照されたい。

<Blackwell製品>

・B200(GB200版)

・B200(DGX/HGX版)

・B100(HGX版)

<Hopper製品:参考?>

・Hopper(H100 SXM)

まあ、どうでもいいんですが。

もう、H200とかは、飛ばされている感じだな。

門外漢の浮沈子には、さっぱりな記事だが、気になる点もある。

「Transformerモデルでは、MoE(mixture of experts)と呼ばれる手法を使って並列性を高めることが行なわれている。」

「MoEで演算をする場合、1つのGPUがほかのGPUの処理が終わるまで待つということが発生する。また、複数のGPUでデータのやりとりを行なったりすることに、GPUの処理能力の60%を消費している」

「大規模に並列化されたGPUにおいてそうした「無駄」が生じており、それを削減することに大きな意味がある」

「新しいTransformerモデルの並列性向上手法(EP:Expert Parallelism、TP:Tensor Parallelism)をさらに2分割することで、Blackwellのようなより並列性が高くなっている製品ではAI学習がさらに効率よく演算でき、かつGPU同士の通信を減らして演算効率を上げることが可能」

ダイの製造限界から、2ダイ構成にしたわけだが、転んでもただでは起きないわけだ。

言語モデルの構造を、AIチップ構成に織り込んでいる。

「新しいソフトウェアのトレンドにも対応することで、ハードウェアのレベルでも、ソフトウェアのレベルでも並列性を高めてより効率よくAI学習を実行したようにしたのがBlackwellの狙い」

インテルは、またしても突き放されることになるのではないか。

AMDも追随していると言われるが、浮沈子的には未調査だ。

この件、何かあればまた書く。

<さらに追加>ーーーーーーーーーー

(NVIDIAがデータセンター向けGPU市場で98%のシェアを独占していることが判明、AI性能が明暗を分ける結果に)

https://gigazine.net/news/20240205-nvidia-gpu-market/

「2023年のデータセンター向けGPU市場におけるNVIDIAのシェアが98%」

べらぼーめい・・・。

元になったXへの投稿は、やっぱヤバ過ぎたのか、削除されているようだ。

まあいい。

「2023年におけるNVIDIAのデータセンター向けGPUの売上は372億ドル(約5兆5220億円)で、2024年には457億ドル(約6兆7840億円)の収益を上げると予測されているとのこと。これに対し、2番手であるAMDの収益はそれぞれ4億6100万ドル(約684億2500万円)と21億ドル(約3110億円)に過ぎない」

やれやれ・・・。

「一方、Intelは次期AIチップの「Gaudi 3」でNVIDIAのH100やAMDのMI300に対抗するとしていますが、上記のグラフの通りシェア奪還はごくわずかにとどまるとの公算が大きい」(グラフは削除されています。)

「192GBのRAMと8枚のカードを備えたAMDのMI300Xは前世代のMI250を大きくしのぐ性能を秘めている」

色々調べたんだが、この記事が分かりやすい。

(AI=NVIDIAの牙城を崩すAMDの新GPU「Instinct MI300X」)

https://pc.watch.impress.co.jp/docs/column/ubiq/1553731.html

「AMDは、同社がNVIDIA H100対抗と位置付けるGPUの「Instinct MI300X」、APUの「Instinct MI300A」という2つの製品を発表」

「前者はデータセンターでのAI学習・推論向け、後者はデータセンターでのHPC処理向け」(HPC:ハイパフォーマンスコンピューティング:ここではAI用途以外の高速大容量処理用途らしい)

性能としてはAMDのインスティンクトの方が名目上は上な感じだが、業界の流れを変えることが出来るかどうかはビミョーだ(2024年中はムリポ)。

もう、クラウドサイドのAIチップは、エヌビディア一択と言って差し支えない。

既に見たように、Blackwellアーキテクチャへのシフトが始まっているしな。

すると、H200の位置付けは、単なるつなぎということになる。

(NVIDIAがAIおよびHPC向けGPU「H200」を発表、H100と比べて推論速度が2倍でHPC性能はx86 CPUの110倍)

https://gigazine.net/news/20231114-nvidia-h200-hopper/

「新たに発表されたH200には高速かつ大容量なメモリ技術「HBM3e」が採用されており、メモリ容量は141GB、メモリ帯域幅は4.8TB毎秒に達しています。H200は高性能なメモリを採用することでH100と比べて2倍の推論速度を実現」

市場投入時期も、ほぼ同時ということになりかねない。

N社は、収益を最大化するために、売り手市場での独占的地位を最大限に利用するだろう。

市場はAIチップに飢えている。

AMDは、この異常な状況の中で、H100同等程度の性能で勝負しようとしている。

それはインテルも同じだ。

N社は、市場の動きを見ながら、H100からH200への切り替え時期、B100シリーズの投入のタイミングを計ることが出来る。

状況が動くとしたら、2025年以降だろうな。

少なくとも今年はN社の一人勝ちが続くだろう。

<さらにさらに追加>ーーーーーーーーーー

(NVIDIA、データセンター向けGPU市場におけるシェアが98%!)

https://note.com/salty02/n/n4dda633066c7

「生成AIブームの中、大企業がこぞって演算力の高いGPUの確保に奔走。」

削除されていたグラフも、画像として残っていた!。

なんと、2018年以降は、90%台を維持している。

昨日今日始まった話ではないのだ・・・。

最近のコメント