🐱AI:北極に舞う雪 ― 2024年04月27日 00:59

AI:北極に舞う雪

(無料で商用利用可能なSQL生成・コーディング・命令フォローなどのエンタープライズタスクに最適化された大規模言語モデル「Snowflake Arctic」が登場)

https://gigazine.net/news/20240426-arctic-open-efficient-foundation-language-models-snowflake/

「トップレベルのエンタープライズ向け大規模言語モデル(LLM)」

この記事の面白いところは、記事本文の中ではAIとは一言も言ってないところだな。

タイトルだけ見た時には、AIの記事とは、一瞬、気付かなかった。

が、もちろん、AIそのものであることは間違いない。

「トレーニングにかかる費用は200万ドル(約3億1000万円)未満」

これが安いのか高いのかは値ごろ感がないので分からないが、比較表に登場しているデータブリックスのDBRXが15億円くらいという記事があったように記憶しているから(つーことは、それが安いと宣伝しているわけだな)、それと比べても安いと言うことなんだろう。

「トレーニングに必要な計算量はアクティブパラメーターの数とトレーニングトークンの積に比例するとのこと。トレーニング効率が高いモデルでは、ユーザーが手頃にカスタムモデルを作成できるというメリットがあります。」

これからのAIは、この「トレーニング効率の高さ」が一つの指標になるのかもしれない。

「Snowflake Arcticでは独自のDense-MoEハイブリッドトランスフォーマーアーキテクチャを使用」

「合計128人の「専門家」に合計4800億(480B)パラメーターが振り分けられており、トレーニングと推論では専門家の中から合計170億(17B)パラメーターだけが使用」

もう、MoEは当たり前で、そのMoEの出来不出来が問われる話だ。

「フェーズごとに学習内容を変更し、最初の1兆(1T)トークン分にあたるフェーズ1では常識的な推論など一般的なスキルを学習し、後半のフェーズ2とフェーズ3でコーディングや数学など複雑な内容を学習する」

「トレーニングだけでなく推論も効率良く行える」

「少ない計算量で高いパフォーマンスを発揮する」

AIにおける省エネ省資源に注目している浮沈子は、この辺りの指標には興味を惹かれるところだ。

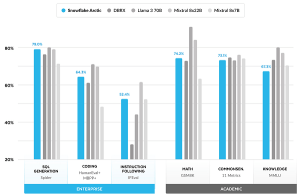

が、まあ、ベンチマーク自体は「並み」の性能という感じだな(画像参照)。

むしろ、リャマ3の70Bやミクストラル8x22Bのバランスの良さが光る。

MoEは、確かにコスト効率は高いかもしれないけど、中規模以下のモデルで絶対性能が突出して高いわけではない。

スケーラビリティの良さを最大限に生かして、超巨大LLMに展開してこそ真価を発揮するような気がする(未確認)。

デモページがあると言うので、早速、例の質問を・・・。

(スノーフレーク北極)

https://arctic.streamlit.app/

「Q.地球外生命はいますか」

「A.私は地球外生命が存在するかどうかに関する具体的な情報を持っていませんが、科学者は、宇宙には多くの惑星があり、それらの惑星上で生命が誕生する可能性があると考えています。しかし、現時点では、地球外生命の存在は確証されていません。」

「Q.火星移民は可能ですか」

「A.火星への移民は、現在技術的に可能ですが、まだ実現していません。火星への旅行や滞在は非常に困難であり、長期間の宇宙飛行や火星上での生活に考慮すべき多くの問題があります。これらの問題には、宇宙飛行時の人体への影響、火星上での生活環境(例えば、空気、水、食料など)、火星での建設や維持管理などが含まれます。

科学者やエンジニアは現在、火星への移民を可能にするために多くの研究や開発を行っていますが、まだ完全な火星移民は実現していません。今後もこの分野での進展が期待されています。」

シンプルで常識的な範囲での回答で、まあまあの出来な気がする。

放射線や重力などの、身体的リスクへの具体な言及はないけど、ショートアンサーとしては十分だ。

SQLの生成やコーディングなどにフォーカスしてチューニングしていると言うので、そっちの能力に期待というところか。

このところ、毎日のようにAI絡みの記事が上がっている。

(NVIDIAのジェンスン・フアンCEOが「H200」搭載AIシステムをOpenAIのサム・アルトマンCEOに直接手渡す)

https://gigazine.net/news/20240426-nvidia-ceo-hand-delivers-h200-openai/

「NVIDIAは2023年11月に、AIおよびハイパフォーマンス・コンピューティング(HPC)向けのGPU「H200」を発表」

先日、H200の記事をフォローしたばかりなのにな・・・。

「2024年3月末にはH200の出荷が始まった」

「現地時間の2024年4月24日、なんとNVIDIAのフアンCEOが重要な顧客であるOpenAIに直接H200搭載AIサーバーのDGX H200を送り届けた」

「世界初のNVIDIAのDGX H200が、『AI、コンピューティング、そして人類の発展』にささげるために、ジェンスンによってOpenAIに手渡されました」(OpenAI共同創業者のグレッグ・ブロックマン氏)

「H200は前世代の「H100」と比較して推論速度が2倍、x86 CPUと比べてHPC性能が110倍になっているとアピールされています。」

「H200の性能は前世代のH100から大きく進歩しており、NVIDIAの「AIワークロードをスーパーチャージするための世界で最も強力なGPU」という主張に反論する人はほとんどいない」(テクノロジー系メディアのTom's Hardware)

既にこのブログでも取り上げたように、N社の製品リリースは、次世代のブラックウェルアーキテクチャであるB200シリーズに焦点が移っている。

今年後半と言われるタイミングは多少ずれ込むかもしれないけど、H100やH200の数倍の言われるパフォーマンスは、その他大勢(AMD、インテル、エトセエトセ・・・)を、再び大きく突き放すに違いない。

他社は、そのタイミングで、H100の競合製品を投入することになる。

勝負にならないだろうな。

そんな、ハードウェア、開発環境の爆速化と、スノーフレークアーティクルな効率を追求したLLMが両輪となって、AIの性能は一層向上して区に違いない。

その流れには、チップ製造技術の進展も絡んでくる。

(TSMCが1.6nm世代の半導体製造プロセス「A16」を2026年中に量産開始すると発表)

https://gigazine.net/news/20240426-tsmc-a16-arrive-in-2026/

「私たちは、AIがデータセンターだけでなく、パソコン、モバイル機器、自動車、さらにはモノのインターネットでも稼働する世界を迎えようとしています。TSMCでは、お客様のAIに関するビジョンを実現するために、最も包括的な技術を提供しています。それは、世界最先端のシリコンから最も幅広い先進パッケージングと3D ICプラットフォームのポートフォリオ、そしてデジタルの世界と現実の世界を統合する特殊技術に至るまで及びます」

1.6ナノメートル(16オングストローム)というのが、どれ程凄まじいかといえば、DNAの塩基対より短いという例えがピンとくる(浮沈子だけかあ?)。

(細胞から個体へ - ゲノム・遺伝子・タンパク質)

https://tsukuba.riken.jp/topics/assets/genome.pdf

「1塩基対の直径は2nm」

べらぼーめ・・・。

人類はとうとう、分子レベルでの微細加工を商業化するまでに至っている。

21世紀は、まぎれもなく訪れている。

20世紀人間な浮沈子は、微細加工技術がサブミクロン(100ナノメートル未満)になったところで、息切れしてトレースを諦めたからな。

現在は、極端紫外線リソグラフィーが最先端だ。

(極端紫外線リソグラフィー)

https://en.wikipedia.org/wiki/Extreme_ultraviolet_lithography

「インテル、キヤノン、ニコン (当時のこの分野のリーダー) に加え、オランダの企業ASMLとシリコンバレー グループ (SVG) もライセンスを求めていました。」(1990年代)

「日本企業は当時強力な技術的競争相手であり、米国企業を犠牲にして税金で資金提供された研究から利益を得るべきではないと考えられていたため、議会は日本企業に必要な許可を拒否した。」

「2001 年に SVG は ASML に買収され、ASML が重要なテクノロジーの唯一の後援者となりました。」

まあ、いろいろ紆余曲折があったわけだ。

「かつては中小企業だった ASML はスキャナー生産の世界リーダーとなり、この最先端技術の独占企業」

「米国のライセンス所有者はオランダ当局にこれらの機械を中国に販売しないよう圧力をかけました。」

記事には、重箱の隅を突っつく話が山ほど出ているが、ばっさり割愛する。

まあ、どうでもいいんですが。

前にも書いたけど、AIはAIチップを製造することは出来ないからな。

AIがシンギュラリティを超えても、AIチップを作り出すことは出来ないだろう(たぶん)。

って、いつまで言ってられるのかな・・・。

(無料で商用利用可能なSQL生成・コーディング・命令フォローなどのエンタープライズタスクに最適化された大規模言語モデル「Snowflake Arctic」が登場)

https://gigazine.net/news/20240426-arctic-open-efficient-foundation-language-models-snowflake/

「トップレベルのエンタープライズ向け大規模言語モデル(LLM)」

この記事の面白いところは、記事本文の中ではAIとは一言も言ってないところだな。

タイトルだけ見た時には、AIの記事とは、一瞬、気付かなかった。

が、もちろん、AIそのものであることは間違いない。

「トレーニングにかかる費用は200万ドル(約3億1000万円)未満」

これが安いのか高いのかは値ごろ感がないので分からないが、比較表に登場しているデータブリックスのDBRXが15億円くらいという記事があったように記憶しているから(つーことは、それが安いと宣伝しているわけだな)、それと比べても安いと言うことなんだろう。

「トレーニングに必要な計算量はアクティブパラメーターの数とトレーニングトークンの積に比例するとのこと。トレーニング効率が高いモデルでは、ユーザーが手頃にカスタムモデルを作成できるというメリットがあります。」

これからのAIは、この「トレーニング効率の高さ」が一つの指標になるのかもしれない。

「Snowflake Arcticでは独自のDense-MoEハイブリッドトランスフォーマーアーキテクチャを使用」

「合計128人の「専門家」に合計4800億(480B)パラメーターが振り分けられており、トレーニングと推論では専門家の中から合計170億(17B)パラメーターだけが使用」

もう、MoEは当たり前で、そのMoEの出来不出来が問われる話だ。

「フェーズごとに学習内容を変更し、最初の1兆(1T)トークン分にあたるフェーズ1では常識的な推論など一般的なスキルを学習し、後半のフェーズ2とフェーズ3でコーディングや数学など複雑な内容を学習する」

「トレーニングだけでなく推論も効率良く行える」

「少ない計算量で高いパフォーマンスを発揮する」

AIにおける省エネ省資源に注目している浮沈子は、この辺りの指標には興味を惹かれるところだ。

が、まあ、ベンチマーク自体は「並み」の性能という感じだな(画像参照)。

むしろ、リャマ3の70Bやミクストラル8x22Bのバランスの良さが光る。

MoEは、確かにコスト効率は高いかもしれないけど、中規模以下のモデルで絶対性能が突出して高いわけではない。

スケーラビリティの良さを最大限に生かして、超巨大LLMに展開してこそ真価を発揮するような気がする(未確認)。

デモページがあると言うので、早速、例の質問を・・・。

(スノーフレーク北極)

https://arctic.streamlit.app/

「Q.地球外生命はいますか」

「A.私は地球外生命が存在するかどうかに関する具体的な情報を持っていませんが、科学者は、宇宙には多くの惑星があり、それらの惑星上で生命が誕生する可能性があると考えています。しかし、現時点では、地球外生命の存在は確証されていません。」

「Q.火星移民は可能ですか」

「A.火星への移民は、現在技術的に可能ですが、まだ実現していません。火星への旅行や滞在は非常に困難であり、長期間の宇宙飛行や火星上での生活に考慮すべき多くの問題があります。これらの問題には、宇宙飛行時の人体への影響、火星上での生活環境(例えば、空気、水、食料など)、火星での建設や維持管理などが含まれます。

科学者やエンジニアは現在、火星への移民を可能にするために多くの研究や開発を行っていますが、まだ完全な火星移民は実現していません。今後もこの分野での進展が期待されています。」

シンプルで常識的な範囲での回答で、まあまあの出来な気がする。

放射線や重力などの、身体的リスクへの具体な言及はないけど、ショートアンサーとしては十分だ。

SQLの生成やコーディングなどにフォーカスしてチューニングしていると言うので、そっちの能力に期待というところか。

このところ、毎日のようにAI絡みの記事が上がっている。

(NVIDIAのジェンスン・フアンCEOが「H200」搭載AIシステムをOpenAIのサム・アルトマンCEOに直接手渡す)

https://gigazine.net/news/20240426-nvidia-ceo-hand-delivers-h200-openai/

「NVIDIAは2023年11月に、AIおよびハイパフォーマンス・コンピューティング(HPC)向けのGPU「H200」を発表」

先日、H200の記事をフォローしたばかりなのにな・・・。

「2024年3月末にはH200の出荷が始まった」

「現地時間の2024年4月24日、なんとNVIDIAのフアンCEOが重要な顧客であるOpenAIに直接H200搭載AIサーバーのDGX H200を送り届けた」

「世界初のNVIDIAのDGX H200が、『AI、コンピューティング、そして人類の発展』にささげるために、ジェンスンによってOpenAIに手渡されました」(OpenAI共同創業者のグレッグ・ブロックマン氏)

「H200は前世代の「H100」と比較して推論速度が2倍、x86 CPUと比べてHPC性能が110倍になっているとアピールされています。」

「H200の性能は前世代のH100から大きく進歩しており、NVIDIAの「AIワークロードをスーパーチャージするための世界で最も強力なGPU」という主張に反論する人はほとんどいない」(テクノロジー系メディアのTom's Hardware)

既にこのブログでも取り上げたように、N社の製品リリースは、次世代のブラックウェルアーキテクチャであるB200シリーズに焦点が移っている。

今年後半と言われるタイミングは多少ずれ込むかもしれないけど、H100やH200の数倍の言われるパフォーマンスは、その他大勢(AMD、インテル、エトセエトセ・・・)を、再び大きく突き放すに違いない。

他社は、そのタイミングで、H100の競合製品を投入することになる。

勝負にならないだろうな。

そんな、ハードウェア、開発環境の爆速化と、スノーフレークアーティクルな効率を追求したLLMが両輪となって、AIの性能は一層向上して区に違いない。

その流れには、チップ製造技術の進展も絡んでくる。

(TSMCが1.6nm世代の半導体製造プロセス「A16」を2026年中に量産開始すると発表)

https://gigazine.net/news/20240426-tsmc-a16-arrive-in-2026/

「私たちは、AIがデータセンターだけでなく、パソコン、モバイル機器、自動車、さらにはモノのインターネットでも稼働する世界を迎えようとしています。TSMCでは、お客様のAIに関するビジョンを実現するために、最も包括的な技術を提供しています。それは、世界最先端のシリコンから最も幅広い先進パッケージングと3D ICプラットフォームのポートフォリオ、そしてデジタルの世界と現実の世界を統合する特殊技術に至るまで及びます」

1.6ナノメートル(16オングストローム)というのが、どれ程凄まじいかといえば、DNAの塩基対より短いという例えがピンとくる(浮沈子だけかあ?)。

(細胞から個体へ - ゲノム・遺伝子・タンパク質)

https://tsukuba.riken.jp/topics/assets/genome.pdf

「1塩基対の直径は2nm」

べらぼーめ・・・。

人類はとうとう、分子レベルでの微細加工を商業化するまでに至っている。

21世紀は、まぎれもなく訪れている。

20世紀人間な浮沈子は、微細加工技術がサブミクロン(100ナノメートル未満)になったところで、息切れしてトレースを諦めたからな。

現在は、極端紫外線リソグラフィーが最先端だ。

(極端紫外線リソグラフィー)

https://en.wikipedia.org/wiki/Extreme_ultraviolet_lithography

「インテル、キヤノン、ニコン (当時のこの分野のリーダー) に加え、オランダの企業ASMLとシリコンバレー グループ (SVG) もライセンスを求めていました。」(1990年代)

「日本企業は当時強力な技術的競争相手であり、米国企業を犠牲にして税金で資金提供された研究から利益を得るべきではないと考えられていたため、議会は日本企業に必要な許可を拒否した。」

「2001 年に SVG は ASML に買収され、ASML が重要なテクノロジーの唯一の後援者となりました。」

まあ、いろいろ紆余曲折があったわけだ。

「かつては中小企業だった ASML はスキャナー生産の世界リーダーとなり、この最先端技術の独占企業」

「米国のライセンス所有者はオランダ当局にこれらの機械を中国に販売しないよう圧力をかけました。」

記事には、重箱の隅を突っつく話が山ほど出ているが、ばっさり割愛する。

まあ、どうでもいいんですが。

前にも書いたけど、AIはAIチップを製造することは出来ないからな。

AIがシンギュラリティを超えても、AIチップを作り出すことは出来ないだろう(たぶん)。

って、いつまで言ってられるのかな・・・。

コメントをどうぞ

※メールアドレスとURLの入力は必須ではありません。 入力されたメールアドレスは記事に反映されず、ブログの管理者のみが参照できます。

※なお、送られたコメントはブログの管理者が確認するまで公開されません。

※投稿には管理者が設定した質問に答える必要があります。