🐱AI:ガウディ3:水冷も! ― 2024年04月24日 22:08

AI:ガウディ3:水冷も!

(IntelがNVIDIAに対抗して発表したAIアクセラレータ「Gaudi 3」の実物写真が公開中)

https://gigazine.net/news/20240423-intel-gaudi-3-photo-report/

「Gaudi 3は空冷式と水冷式が用意されるとのことで、量産品は空冷式が2024年第3四半期(7月~9月)、水冷式が2024年第4四半期(10月~12月)にリリースされる予定」

独走するエヌビディアに待ったをかけられるかどうか。

「Intelは、Gaudi 3がAI学習性能とAI推論性能の両面でNVIDIAのAI特化GPU「H100」よりも高い性能を発揮すると述べており、2024年後半に量産を開始する予定」

「2020年に発表された前世代のGaudi 2は7nmプロセスで設計されていますが、Gaudi 3は5nmプロセスで設計されています。」

「シリコンパッケージは2つのダイで構成されており、それぞれに48MBのSRAM、16個のTPC(テンソル処理コア)、メディアエンジンが搭載」

このAIチップについては、以前にも取り上げている。

(AI:AIチップの味)

http://kfujito2.asablo.jp/blog/2024/04/12/9675288

「(IntelがAIアクセラレータ「Gaudi 3」を発表、NVIDIAのH100より高速かつ低消費電力で一部テストではH200にも勝利)

https://gigazine.net/news/20240410-intel-ai-accelerator-gaudi-3/

「IntelがAIアクセラレータ「Gaudi 3」を2024年4月9日に発表しました。」

「NVIDIAのAI特化GPU「H100」よりも高い性能」」

インテルとしては、エヌビディアの独走を許すわけにはいかないだろう。

コンパクトな言語モデルが登場してきているとはいえ、スーパーLLMの需要はまだまだ続くに違いない。

また、サービスとしてのAIの活用だけではなく、自らホストしてチューニングしたいという要求もあるはずだ。

クラウドサイドのAIだって、これからいくらでも大化けしそうな予感がする。

もっとも、データセンターのエネルギー的(電力や冷却能力)ネックが問題だがな。

年内には、H200がリリースされると言われているが、ガウディ3はそれも上回るとされているようだ。

(NVIDIA H200 Tensor コア GPU)

https://www.nvidia.com/ja-jp/data-center/h200/

「この製品が発売開始になりましたらお知らせいたします。」

まあ、出てみなければ分からんけどな。

MoEや、教育の最適化で、スケール的な問題が高度に解決されれば、今度はその手法をスケールアップして大規模モデルに適用し、一層大規模にしてハイパーLLMへと進化することは目に見えている。

数(規模)は正義だ。

そういった言語ベースの進化と同時に、マルチモーダル化という流れも見えてきている。

チップベースで、それをどう実現するのかは知らない。

いずれにしても、計算資源があり過ぎて困ることはない。

質より量とは言わないけど、AIの世界で量は絶対の正義だろう。

質も量も、湯水のごとく消費される世界だ。

水冷チップなんて、久々な気がする(浮沈子が知らないだけかも)。

ブラウン管なモニターとにらめっこし、ハードディスクをスタックして自作していた時代は歴史の彼方に消えた。

AIチップの世界もまた、言語モデルと同様に、絶え間ない進化が続きそうだな・・・。

<以下追加>ーーーーーーーーーー

(NVIDIA Blackwell GPU 発表!)

https://gdep-sol.co.jp/news-nvidia-brackwell-gpu-gtc24/

「NVIDIA最大の開発者向けカンファレンス「NVIDIA GTC 2024」において、新しいGPUアーキテクチャ「Blackwell」が発表されました。」

「「Blackwell GPU」は、データセンターやサーバー向けのGPUとなり、NVIDIA H100 などの「Hopper GPU」の後継となります。」

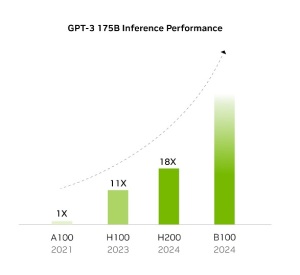

引用したエヌビディアのページのグラフ(画像参照)に出ていたので、ちょろっと調べたら、1か月余り前に発表されていた。

「「Blackwell」は、2024年後半から発売開始予定となり、数兆パラメータの大規模言語モデルによるリアルタイム生成 AI を構築・実行することができると発表しています。」

べらぼーめ・・・。

アーキテクチャの流れは以下の通り。

・2020年発表 Ampere アーキテクチャ(NVIDIA A100 Tensor Core GPU)

・2022年発表 Hopper アーキテクチャ(NVIDIA H100 Tensor Core GPU)

・2024年発表 Blackwell アーキテクチャ(NVIDIA B100 Tensor Core GPU)

なお、実際の製品名は、どうやらB200がメインで、B100というのは性能を落とした普及版らしい(未確認)。

(AI特化設計になったNVIDIA Blackwell、並列性を向上する仕組みが強化)

https://pc.watch.impress.co.jp/docs/column/ubiq/1577897.html

「NVIDIAは3月18日~3月20日(米国時間)の3日間に渡り、同社のAIやデータセンター向け半導体などに関する話題を扱うフラグシップ年次イベント「GTC」を、米国カリフォルニア州サンノゼのサンノゼコンベンションセンターにおいて開催」

「基調講演の中で、新しいAI/データセンター向けGPUアーキテクチャ「Blackwell」が発表」

「最初の製品として「NVIDIA B200 Tensor Core GPU」(以下B200)、「NVIDIA GB200 Superchip」(以下GB200)の2つを今年(2024年)中に投入する計画」

「今回発表されたBlackwellにはTDPの違いで3つのグレードの製品が用意」(Thermal Design Power:熱設計電力)

「GB200に採用されているフルスペックのB200は、前述の通り1,200WのTDPになっている。それに対してDGX B200やHGX B200に採用されているB200は、TDPが1,000Wになっており、それに合わせてフルスペックのB200に比べてクロック周波数や演算器の数などが少し下げられている」(どのように調整しているかは非公表)

「さらに、下位モデルとしてB100という製品も用意される。」(700Wという従来のH100と同じTDP)

「いずれも2ダイ/1パッケージは同様(その証拠にメモリ帯域や容量などはB200と変わらない)」

「このB100では、H100 SXMに比べるとFP64の数字は劣っているが、Tensorコアを利用した演算では上回っている、そうした位置づけの製品」

記事には、性能を比較した表が載っているので、興味がある方はそちらを参照されたい。

<Blackwell製品>

・B200(GB200版)

・B200(DGX/HGX版)

・B100(HGX版)

<Hopper製品:参考?>

・Hopper(H100 SXM)

まあ、どうでもいいんですが。

もう、H200とかは、飛ばされている感じだな。

門外漢の浮沈子には、さっぱりな記事だが、気になる点もある。

「Transformerモデルでは、MoE(mixture of experts)と呼ばれる手法を使って並列性を高めることが行なわれている。」

「MoEで演算をする場合、1つのGPUがほかのGPUの処理が終わるまで待つということが発生する。また、複数のGPUでデータのやりとりを行なったりすることに、GPUの処理能力の60%を消費している」

「大規模に並列化されたGPUにおいてそうした「無駄」が生じており、それを削減することに大きな意味がある」

「新しいTransformerモデルの並列性向上手法(EP:Expert Parallelism、TP:Tensor Parallelism)をさらに2分割することで、Blackwellのようなより並列性が高くなっている製品ではAI学習がさらに効率よく演算でき、かつGPU同士の通信を減らして演算効率を上げることが可能」

ダイの製造限界から、2ダイ構成にしたわけだが、転んでもただでは起きないわけだ。

言語モデルの構造を、AIチップ構成に織り込んでいる。

「新しいソフトウェアのトレンドにも対応することで、ハードウェアのレベルでも、ソフトウェアのレベルでも並列性を高めてより効率よくAI学習を実行したようにしたのがBlackwellの狙い」

インテルは、またしても突き放されることになるのではないか。

AMDも追随していると言われるが、浮沈子的には未調査だ。

この件、何かあればまた書く。

<さらに追加>ーーーーーーーーーー

(NVIDIAがデータセンター向けGPU市場で98%のシェアを独占していることが判明、AI性能が明暗を分ける結果に)

https://gigazine.net/news/20240205-nvidia-gpu-market/

「2023年のデータセンター向けGPU市場におけるNVIDIAのシェアが98%」

べらぼーめい・・・。

元になったXへの投稿は、やっぱヤバ過ぎたのか、削除されているようだ。

まあいい。

「2023年におけるNVIDIAのデータセンター向けGPUの売上は372億ドル(約5兆5220億円)で、2024年には457億ドル(約6兆7840億円)の収益を上げると予測されているとのこと。これに対し、2番手であるAMDの収益はそれぞれ4億6100万ドル(約684億2500万円)と21億ドル(約3110億円)に過ぎない」

やれやれ・・・。

「一方、Intelは次期AIチップの「Gaudi 3」でNVIDIAのH100やAMDのMI300に対抗するとしていますが、上記のグラフの通りシェア奪還はごくわずかにとどまるとの公算が大きい」(グラフは削除されています。)

「192GBのRAMと8枚のカードを備えたAMDのMI300Xは前世代のMI250を大きくしのぐ性能を秘めている」

色々調べたんだが、この記事が分かりやすい。

(AI=NVIDIAの牙城を崩すAMDの新GPU「Instinct MI300X」)

https://pc.watch.impress.co.jp/docs/column/ubiq/1553731.html

「AMDは、同社がNVIDIA H100対抗と位置付けるGPUの「Instinct MI300X」、APUの「Instinct MI300A」という2つの製品を発表」

「前者はデータセンターでのAI学習・推論向け、後者はデータセンターでのHPC処理向け」(HPC:ハイパフォーマンスコンピューティング:ここではAI用途以外の高速大容量処理用途らしい)

性能としてはAMDのインスティンクトの方が名目上は上な感じだが、業界の流れを変えることが出来るかどうかはビミョーだ(2024年中はムリポ)。

もう、クラウドサイドのAIチップは、エヌビディア一択と言って差し支えない。

既に見たように、Blackwellアーキテクチャへのシフトが始まっているしな。

すると、H200の位置付けは、単なるつなぎということになる。

(NVIDIAがAIおよびHPC向けGPU「H200」を発表、H100と比べて推論速度が2倍でHPC性能はx86 CPUの110倍)

https://gigazine.net/news/20231114-nvidia-h200-hopper/

「新たに発表されたH200には高速かつ大容量なメモリ技術「HBM3e」が採用されており、メモリ容量は141GB、メモリ帯域幅は4.8TB毎秒に達しています。H200は高性能なメモリを採用することでH100と比べて2倍の推論速度を実現」

市場投入時期も、ほぼ同時ということになりかねない。

N社は、収益を最大化するために、売り手市場での独占的地位を最大限に利用するだろう。

市場はAIチップに飢えている。

AMDは、この異常な状況の中で、H100同等程度の性能で勝負しようとしている。

それはインテルも同じだ。

N社は、市場の動きを見ながら、H100からH200への切り替え時期、B100シリーズの投入のタイミングを計ることが出来る。

状況が動くとしたら、2025年以降だろうな。

少なくとも今年はN社の一人勝ちが続くだろう。

<さらにさらに追加>ーーーーーーーーーー

(NVIDIA、データセンター向けGPU市場におけるシェアが98%!)

https://note.com/salty02/n/n4dda633066c7

「生成AIブームの中、大企業がこぞって演算力の高いGPUの確保に奔走。」

削除されていたグラフも、画像として残っていた!。

なんと、2018年以降は、90%台を維持している。

昨日今日始まった話ではないのだ・・・。

(IntelがNVIDIAに対抗して発表したAIアクセラレータ「Gaudi 3」の実物写真が公開中)

https://gigazine.net/news/20240423-intel-gaudi-3-photo-report/

「Gaudi 3は空冷式と水冷式が用意されるとのことで、量産品は空冷式が2024年第3四半期(7月~9月)、水冷式が2024年第4四半期(10月~12月)にリリースされる予定」

独走するエヌビディアに待ったをかけられるかどうか。

「Intelは、Gaudi 3がAI学習性能とAI推論性能の両面でNVIDIAのAI特化GPU「H100」よりも高い性能を発揮すると述べており、2024年後半に量産を開始する予定」

「2020年に発表された前世代のGaudi 2は7nmプロセスで設計されていますが、Gaudi 3は5nmプロセスで設計されています。」

「シリコンパッケージは2つのダイで構成されており、それぞれに48MBのSRAM、16個のTPC(テンソル処理コア)、メディアエンジンが搭載」

このAIチップについては、以前にも取り上げている。

(AI:AIチップの味)

http://kfujito2.asablo.jp/blog/2024/04/12/9675288

「(IntelがAIアクセラレータ「Gaudi 3」を発表、NVIDIAのH100より高速かつ低消費電力で一部テストではH200にも勝利)

https://gigazine.net/news/20240410-intel-ai-accelerator-gaudi-3/

「IntelがAIアクセラレータ「Gaudi 3」を2024年4月9日に発表しました。」

「NVIDIAのAI特化GPU「H100」よりも高い性能」」

インテルとしては、エヌビディアの独走を許すわけにはいかないだろう。

コンパクトな言語モデルが登場してきているとはいえ、スーパーLLMの需要はまだまだ続くに違いない。

また、サービスとしてのAIの活用だけではなく、自らホストしてチューニングしたいという要求もあるはずだ。

クラウドサイドのAIだって、これからいくらでも大化けしそうな予感がする。

もっとも、データセンターのエネルギー的(電力や冷却能力)ネックが問題だがな。

年内には、H200がリリースされると言われているが、ガウディ3はそれも上回るとされているようだ。

(NVIDIA H200 Tensor コア GPU)

https://www.nvidia.com/ja-jp/data-center/h200/

「この製品が発売開始になりましたらお知らせいたします。」

まあ、出てみなければ分からんけどな。

MoEや、教育の最適化で、スケール的な問題が高度に解決されれば、今度はその手法をスケールアップして大規模モデルに適用し、一層大規模にしてハイパーLLMへと進化することは目に見えている。

数(規模)は正義だ。

そういった言語ベースの進化と同時に、マルチモーダル化という流れも見えてきている。

チップベースで、それをどう実現するのかは知らない。

いずれにしても、計算資源があり過ぎて困ることはない。

質より量とは言わないけど、AIの世界で量は絶対の正義だろう。

質も量も、湯水のごとく消費される世界だ。

水冷チップなんて、久々な気がする(浮沈子が知らないだけかも)。

ブラウン管なモニターとにらめっこし、ハードディスクをスタックして自作していた時代は歴史の彼方に消えた。

AIチップの世界もまた、言語モデルと同様に、絶え間ない進化が続きそうだな・・・。

<以下追加>ーーーーーーーーーー

(NVIDIA Blackwell GPU 発表!)

https://gdep-sol.co.jp/news-nvidia-brackwell-gpu-gtc24/

「NVIDIA最大の開発者向けカンファレンス「NVIDIA GTC 2024」において、新しいGPUアーキテクチャ「Blackwell」が発表されました。」

「「Blackwell GPU」は、データセンターやサーバー向けのGPUとなり、NVIDIA H100 などの「Hopper GPU」の後継となります。」

引用したエヌビディアのページのグラフ(画像参照)に出ていたので、ちょろっと調べたら、1か月余り前に発表されていた。

「「Blackwell」は、2024年後半から発売開始予定となり、数兆パラメータの大規模言語モデルによるリアルタイム生成 AI を構築・実行することができると発表しています。」

べらぼーめ・・・。

アーキテクチャの流れは以下の通り。

・2020年発表 Ampere アーキテクチャ(NVIDIA A100 Tensor Core GPU)

・2022年発表 Hopper アーキテクチャ(NVIDIA H100 Tensor Core GPU)

・2024年発表 Blackwell アーキテクチャ(NVIDIA B100 Tensor Core GPU)

なお、実際の製品名は、どうやらB200がメインで、B100というのは性能を落とした普及版らしい(未確認)。

(AI特化設計になったNVIDIA Blackwell、並列性を向上する仕組みが強化)

https://pc.watch.impress.co.jp/docs/column/ubiq/1577897.html

「NVIDIAは3月18日~3月20日(米国時間)の3日間に渡り、同社のAIやデータセンター向け半導体などに関する話題を扱うフラグシップ年次イベント「GTC」を、米国カリフォルニア州サンノゼのサンノゼコンベンションセンターにおいて開催」

「基調講演の中で、新しいAI/データセンター向けGPUアーキテクチャ「Blackwell」が発表」

「最初の製品として「NVIDIA B200 Tensor Core GPU」(以下B200)、「NVIDIA GB200 Superchip」(以下GB200)の2つを今年(2024年)中に投入する計画」

「今回発表されたBlackwellにはTDPの違いで3つのグレードの製品が用意」(Thermal Design Power:熱設計電力)

「GB200に採用されているフルスペックのB200は、前述の通り1,200WのTDPになっている。それに対してDGX B200やHGX B200に採用されているB200は、TDPが1,000Wになっており、それに合わせてフルスペックのB200に比べてクロック周波数や演算器の数などが少し下げられている」(どのように調整しているかは非公表)

「さらに、下位モデルとしてB100という製品も用意される。」(700Wという従来のH100と同じTDP)

「いずれも2ダイ/1パッケージは同様(その証拠にメモリ帯域や容量などはB200と変わらない)」

「このB100では、H100 SXMに比べるとFP64の数字は劣っているが、Tensorコアを利用した演算では上回っている、そうした位置づけの製品」

記事には、性能を比較した表が載っているので、興味がある方はそちらを参照されたい。

<Blackwell製品>

・B200(GB200版)

・B200(DGX/HGX版)

・B100(HGX版)

<Hopper製品:参考?>

・Hopper(H100 SXM)

まあ、どうでもいいんですが。

もう、H200とかは、飛ばされている感じだな。

門外漢の浮沈子には、さっぱりな記事だが、気になる点もある。

「Transformerモデルでは、MoE(mixture of experts)と呼ばれる手法を使って並列性を高めることが行なわれている。」

「MoEで演算をする場合、1つのGPUがほかのGPUの処理が終わるまで待つということが発生する。また、複数のGPUでデータのやりとりを行なったりすることに、GPUの処理能力の60%を消費している」

「大規模に並列化されたGPUにおいてそうした「無駄」が生じており、それを削減することに大きな意味がある」

「新しいTransformerモデルの並列性向上手法(EP:Expert Parallelism、TP:Tensor Parallelism)をさらに2分割することで、Blackwellのようなより並列性が高くなっている製品ではAI学習がさらに効率よく演算でき、かつGPU同士の通信を減らして演算効率を上げることが可能」

ダイの製造限界から、2ダイ構成にしたわけだが、転んでもただでは起きないわけだ。

言語モデルの構造を、AIチップ構成に織り込んでいる。

「新しいソフトウェアのトレンドにも対応することで、ハードウェアのレベルでも、ソフトウェアのレベルでも並列性を高めてより効率よくAI学習を実行したようにしたのがBlackwellの狙い」

インテルは、またしても突き放されることになるのではないか。

AMDも追随していると言われるが、浮沈子的には未調査だ。

この件、何かあればまた書く。

<さらに追加>ーーーーーーーーーー

(NVIDIAがデータセンター向けGPU市場で98%のシェアを独占していることが判明、AI性能が明暗を分ける結果に)

https://gigazine.net/news/20240205-nvidia-gpu-market/

「2023年のデータセンター向けGPU市場におけるNVIDIAのシェアが98%」

べらぼーめい・・・。

元になったXへの投稿は、やっぱヤバ過ぎたのか、削除されているようだ。

まあいい。

「2023年におけるNVIDIAのデータセンター向けGPUの売上は372億ドル(約5兆5220億円)で、2024年には457億ドル(約6兆7840億円)の収益を上げると予測されているとのこと。これに対し、2番手であるAMDの収益はそれぞれ4億6100万ドル(約684億2500万円)と21億ドル(約3110億円)に過ぎない」

やれやれ・・・。

「一方、Intelは次期AIチップの「Gaudi 3」でNVIDIAのH100やAMDのMI300に対抗するとしていますが、上記のグラフの通りシェア奪還はごくわずかにとどまるとの公算が大きい」(グラフは削除されています。)

「192GBのRAMと8枚のカードを備えたAMDのMI300Xは前世代のMI250を大きくしのぐ性能を秘めている」

色々調べたんだが、この記事が分かりやすい。

(AI=NVIDIAの牙城を崩すAMDの新GPU「Instinct MI300X」)

https://pc.watch.impress.co.jp/docs/column/ubiq/1553731.html

「AMDは、同社がNVIDIA H100対抗と位置付けるGPUの「Instinct MI300X」、APUの「Instinct MI300A」という2つの製品を発表」

「前者はデータセンターでのAI学習・推論向け、後者はデータセンターでのHPC処理向け」(HPC:ハイパフォーマンスコンピューティング:ここではAI用途以外の高速大容量処理用途らしい)

性能としてはAMDのインスティンクトの方が名目上は上な感じだが、業界の流れを変えることが出来るかどうかはビミョーだ(2024年中はムリポ)。

もう、クラウドサイドのAIチップは、エヌビディア一択と言って差し支えない。

既に見たように、Blackwellアーキテクチャへのシフトが始まっているしな。

すると、H200の位置付けは、単なるつなぎということになる。

(NVIDIAがAIおよびHPC向けGPU「H200」を発表、H100と比べて推論速度が2倍でHPC性能はx86 CPUの110倍)

https://gigazine.net/news/20231114-nvidia-h200-hopper/

「新たに発表されたH200には高速かつ大容量なメモリ技術「HBM3e」が採用されており、メモリ容量は141GB、メモリ帯域幅は4.8TB毎秒に達しています。H200は高性能なメモリを採用することでH100と比べて2倍の推論速度を実現」

市場投入時期も、ほぼ同時ということになりかねない。

N社は、収益を最大化するために、売り手市場での独占的地位を最大限に利用するだろう。

市場はAIチップに飢えている。

AMDは、この異常な状況の中で、H100同等程度の性能で勝負しようとしている。

それはインテルも同じだ。

N社は、市場の動きを見ながら、H100からH200への切り替え時期、B100シリーズの投入のタイミングを計ることが出来る。

状況が動くとしたら、2025年以降だろうな。

少なくとも今年はN社の一人勝ちが続くだろう。

<さらにさらに追加>ーーーーーーーーーー

(NVIDIA、データセンター向けGPU市場におけるシェアが98%!)

https://note.com/salty02/n/n4dda633066c7

「生成AIブームの中、大企業がこぞって演算力の高いGPUの確保に奔走。」

削除されていたグラフも、画像として残っていた!。

なんと、2018年以降は、90%台を維持している。

昨日今日始まった話ではないのだ・・・。

コメントをどうぞ

※メールアドレスとURLの入力は必須ではありません。 入力されたメールアドレスは記事に反映されず、ブログの管理者のみが参照できます。

※なお、送られたコメントはブログの管理者が確認するまで公開されません。

※投稿には管理者が設定した質問に答える必要があります。